INFORMACJA PRASOWA

16 maja 2023

Apple przedstawia nowe ułatwienia dostępu dla osób o ograniczonych zdolnościach kognitywnych, takie jak funkcje konwersji mowy na tekst w czasie rzeczywistym i syntezy własnego głosu, a także możliwość wskazywania i odczytywania w narzędziu Lupa

Jeszcze w tym roku pojawią się nowe rozwiązania programistyczne dla osób z ograniczeniami wzroku, słuchu lub zdolności kognitywnych bądź motorycznych

CUPERTINO, KALIFORNIA Firma Apple zapowiedziała dziś nowe rozwiązania programistyczne dla osób z ograniczeniami wzroku, słuchu lub zdolności kognitywnych bądź motorycznych, a także innowacyjne narzędzia dla osób, które nie mówią lub są zagrożone utratą tej zdolności. Zaprezentowane nowości opierają się na innowacjach sprzętowych i programistycznych, takich jak wbudowane algorytmy uczenia maszynowego chroniące prywatność użytkowników, i dowodzą wieloletniej dbałości Apple o to, by z produktów firmy mogli korzystać wszyscy.

Apple rozwija ułatwienia dostępu w ścisłej współpracy z grupami reprezentującymi użytkowników o bardzo różnych niepełnosprawnościach, by tworzone przez firmę rozwiązania mogły naprawdę odmieniać ludzkie życie. Jeszcze w tym roku osoby o ograniczonych zdolnościach kognitywnych będą mogły korzystać z trybu wspomaganego dostępu, który ułatwi im użytkowanie iPhone’a i iPada, a przy tym pozwoli na większą samodzielność. Osoby nieme będą zaś mogły zamieniać mowę na tekst w czasie rzeczywistym i używać tej funkcji w trakcie połączeń i rozmów. Natomiast osoby zagrożone afazją będą mogły skorzystać z syntezy własnego głosu, by porozumiewać się z rodziną i znajomymi. W trybie wykrywania w narzędziu Lupa pojawi się z kolei opcja wskazywania i odczytywania przeznaczona dla osób niewidomych i słabowidzących. Dzięki niej wskazany przez użytkownika napis zostanie odczytany na głos przez urządzenie, co ułatwi interakcje z różnymi przedmiotami, na przykład ze sprzętem gospodarstwa domowego.

„W Apple od zawsze uważamy, że najlepsza technologia to taka, która jest tworzona z myślą o wszystkich”, powiedział Tim Cook, dyrektor generalny Apple. „Chcemy, by każdy mógł tworzyć, komunikować się i robić to, co kocha, dlatego od lat troszczymy się o większą dostępność technologii. Nowości, które dziś z radością prezentujemy, są tego efektem”.

„Dbanie o dostępność ma wyraz we wszystkim, co robimy w Apple”, oświadczyła Sarah Herrlinger, starsza dyrektorka Apple w pionie Accessibility Policy and Initiatives. „Na każdym etapie prac nad tymi przełomowymi rozwiązaniami korzystaliśmy z rad i uwag osób z różnymi niepełnosprawnościami, by zaspokoić potrzeby różnorodnych użytkowników i zapewnić im nowe metody komunikacji”.

Tryb wspomaganego dostępu ułatwieniem dla użytkowników o ograniczonych zdolnościach kognitywnych

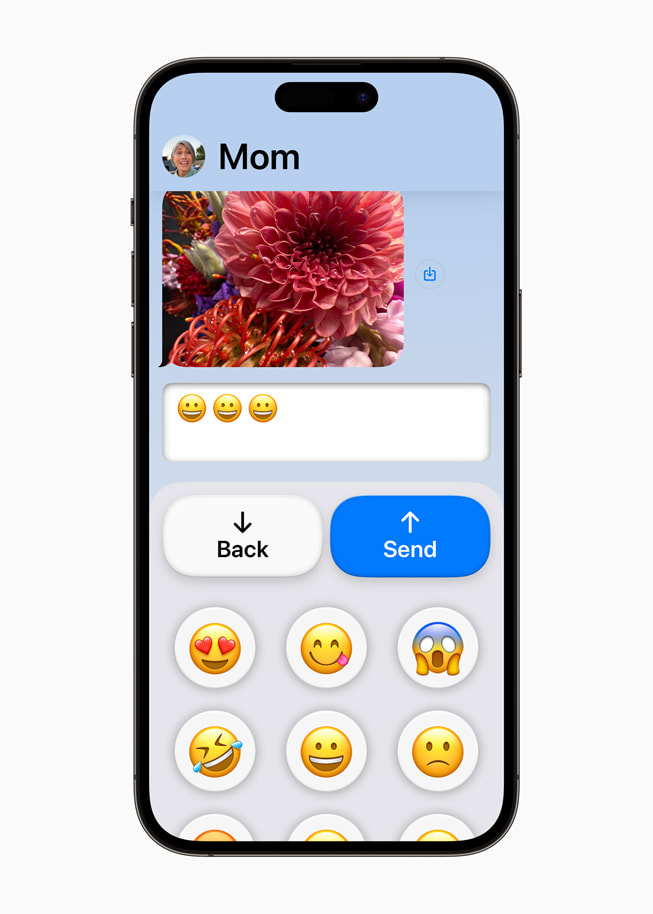

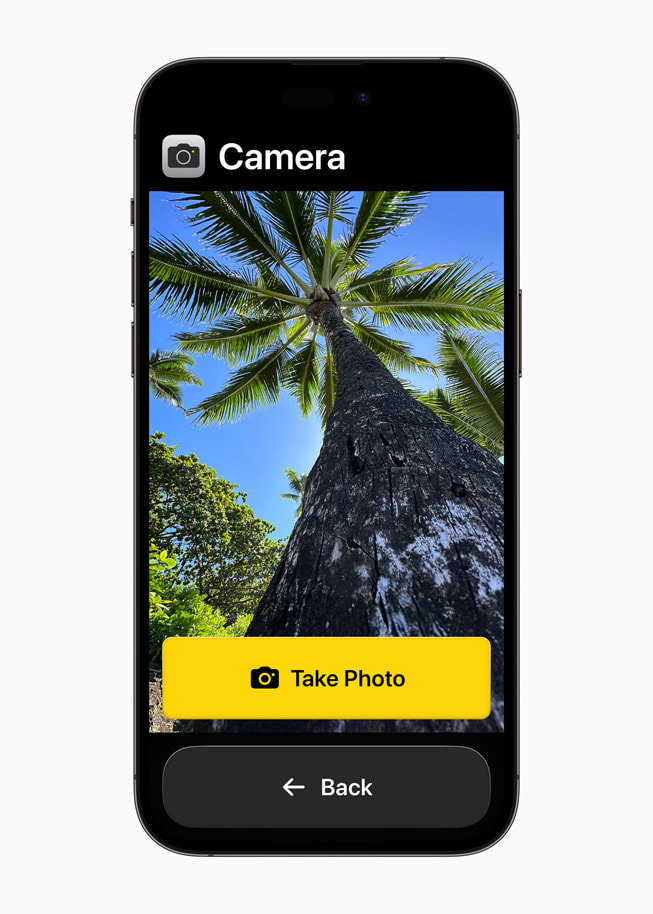

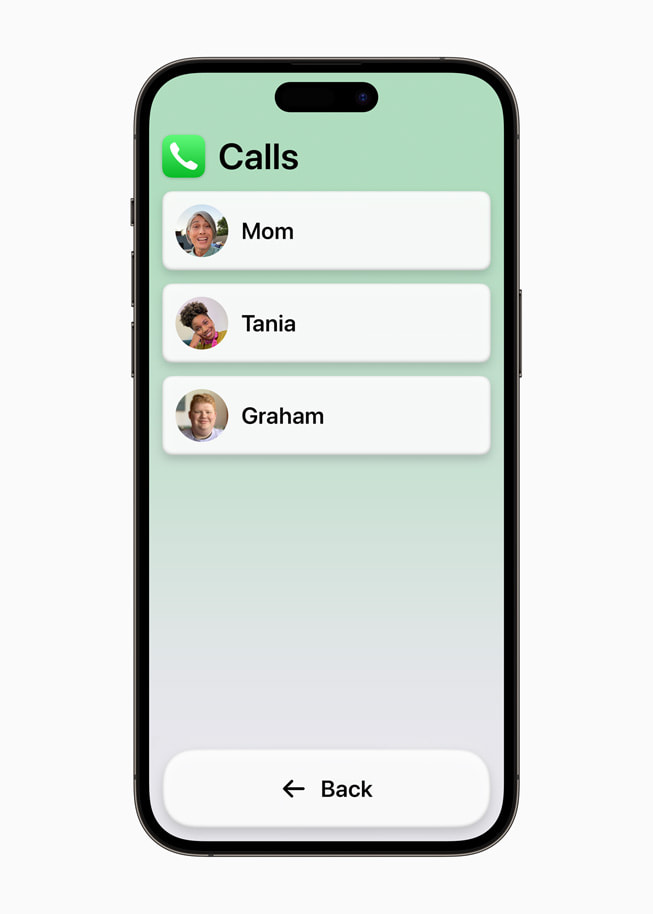

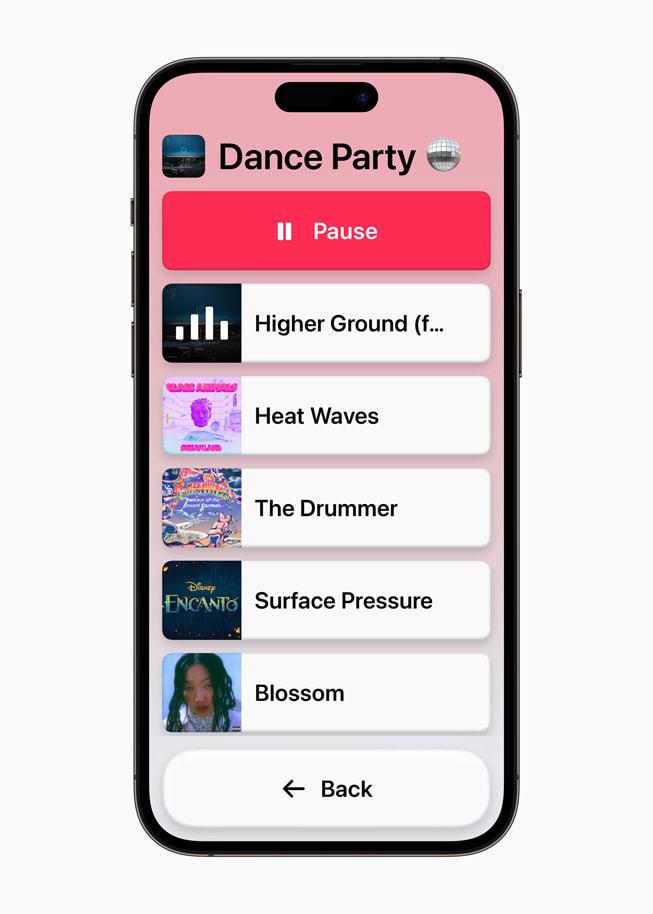

Tryb wspomaganego dostępu to innowacyjny widok, który upraszcza aplikacje i interakcje do ich najważniejszych elementów, tak by zredukować obciążenia poznawcze. W czasie prac nad tym rozwiązaniem uwzględniono komentarze osób z ograniczeniami poznawczymi i ich zaufanych opiekunów. Ponadto skupiono się na ulubionych aktywnościach tych użytkowników, które są przy tym kluczowe dla iPhone’a i iPada: komunikacji z bliskimi, robieniu i oglądaniu zdjęć oraz słuchaniu muzyki.

Tryb wspomaganego dostępu pozwala spersonalizować interfejs aplikacji Telefon i FaceTime, które połączono w jedną aplikację do połączeń, a także aplikacji Wiadomości, Aparat, Zdjęcia i Muzyka. Rozwiązanie umożliwia korzystanie ze specjalnego interfejsu z kontrastowymi przyciskami i dużymi napisami, a do tego obejmuje narzędzia, które pozwalają zaufanym opiekunom dostosować widok do indywidualnych potrzeb wspieranej osoby. Przykładowo, osoba, która preferuje komunikację wizualną, może korzystać z aplikacji Wiadomości z klawiaturą zawierającą tylko emoji i opcją komunikowania się z bliskimi poprzez nagrania wideo. Użytkownicy i ich opiekunowie mają do wyboru dwa widoki aplikacji i ekranu początkowego. Pierwszy jest bardziej wizualny i oparty na siatce, a drugi – przeznaczony dla osób preferujących tekst – ma układ rzędowy.

„Kreatywność społeczności osób z ograniczeniami intelektualnymi i rozwojowymi jest ogromna, jednak trudności fizyczne, wizualne lub intelektualne często uniemożliwiają im dostęp do technologii”, tłumaczy Katy Schmid, starsza dyrektorka ds. inicjatyw krajowych w amerykańskiej organizacji The Arc. „Większa dostępność poznawcza interakcji na iPhonie lub iPadzie oznacza większe szanse na wykształcenie, zatrudnienie, bezpieczeństwo i samodzielność. Pozwala rozwijać potencjał i otwiera nowe możliwości”.

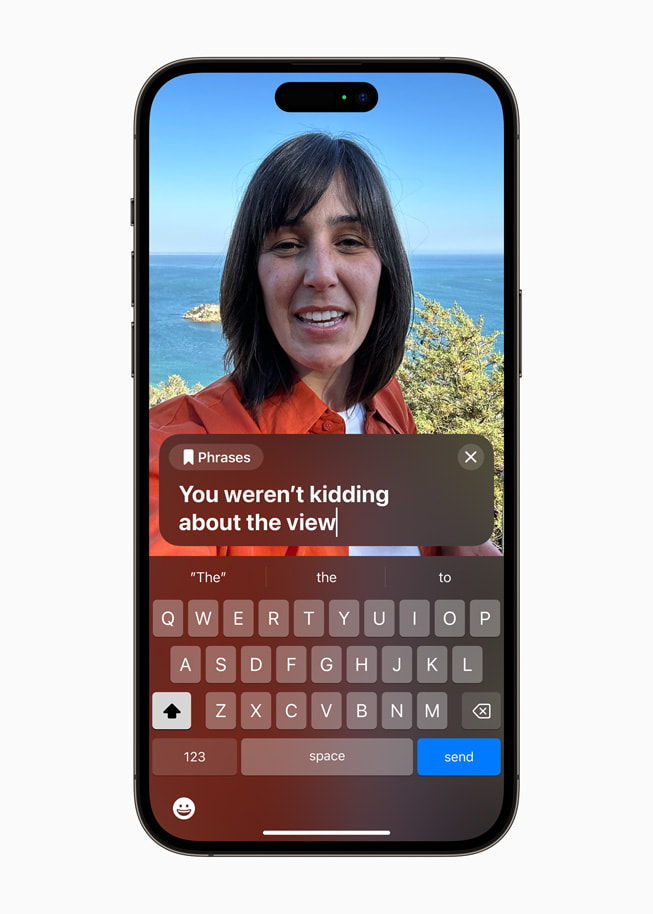

Konwersja mowy na tekst w czasie rzeczywistym i synteza własnego głosu

Za pomocą konwersji mowy na tekst w czasie rzeczywistym i syntezy własnego głosu na iPhonie, iPadzie i Macu można zapisać słowa, które chce się wypowiedzieć, tak by zostały odczytane na głos w czasie połączenia telefonicznego lub w aplikacji FaceTime, a także w trakcie rozmowy twarzą w twarz. Użytkownicy mogą też zapisywać najczęściej używane przez siebie zwroty, by szybko reagować podczas ożywionych dyskusji w domu, w pracy lub wśród znajomych. Na świecie żyją miliony osób, które nie mówią od urodzenia lub utraciły tę zdolność, i właśnie z myślą o nich opracowano funkcję konwersji mowy na tekst w czasie rzeczywistym.

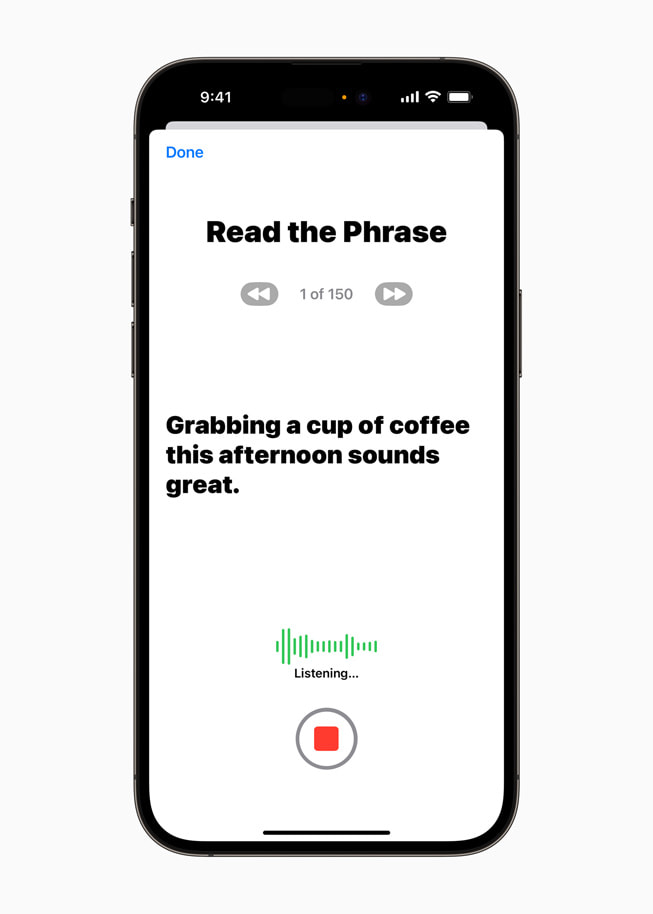

Użytkownicy zagrożeni utratą mowy – na przykład osoby, u których niedawno zdiagnozowano stwardnienie zanikowe boczne (SLA) lub inne schorzenie prowadzące do stopniowego zaniku zdolności mówienia – mogą łatwo i bezpiecznie wygenerować głos, który będzie brzmiał tak jak oni.

W celu uzyskania syntezy własnego głosu należy zarejestrować na iPhonie lub iPadzie 15‑minutowe nagranie dźwiękowe, podczas którego odczytuje się na głos losowo wyświetlane teksty. To ułatwienie wykorzystuje wbudowane w urządzenie algorytmy uczenia maszynowego, dlatego informacje użytkownika i jego prywatność pozostają bezpieczne. Ponadto rozwiązanie współdziała z funkcją konwersji tekstu na mowę w czasie rzeczywistym, dzięki czemu użytkownicy mogą komunikować się z bliskimi własnym głosem1.

„W końcu najważniejsze jest to, by móc porozumiewać się z rodziną i przyjaciółmi”, tłumaczy Philip Green, członek zarządu i rzecznik społeczności osób chorych na SLA w organizacji non profit Team Gleason, którego zdolność mówienia znacząco zmalała od 2018 r., gdy zdiagnozowano u niego SLA. „Możliwość powiedzenia bliskim własnym głosem, że się ich kocha, jest bezcenna, a fakt, że za pomocą iPhone’a w 15 minut można nagrać syntezę swojego głosu, jest czymś niesamowitym”.

Opcja wskazywania i odczytywania w trybie wykrywania w narzędziu Lupa pomaga osobom niewidomym i słabowidzącym

Opcja wskazywania i odczytywania w narzędziu Lupa ułatwia użytkownikom z ograniczeniami wzrokowymi korzystanie z przedmiotów, na których znajdują się różne napisy. Przykładowo, gdy korzysta się ze sprzętów gospodarstwa domowego takich jak kuchenka mikrofalowa, funkcja wskazywania i odczytywania wykorzystuje informacje z aparatu, skaner LiDAR i wbudowane algorytmy uczenia maszynowego, aby odczytać napis na każdym przycisku, po którym użytkownik przesuwa palcem2. Funkcja wskazywania i odczytywania jest wbudowana w aplikację Lupa na iPhonie i iPadzie, a także doskonale zintegrowana z czytnikiem VoiceOver. Może też współdziałać z innymi narzędziami w aplikacji Lupa, takimi jak Wykrywanie osób, Wykrywanie drzwi lub Opisy obrazków, by pomagać użytkownikom w interakcjach z fizycznymi obiektami w ich otoczeniu.

Opcja wskazywania i odczytywania w narzędziu Lupa ułatwia użytkownikom z ograniczeniami wzrokowymi korzystanie z przedmiotów, na których znajdują się różne napisy.

Dodatkowe funkcje

- Osoby głuche i słabosłyszące mogą łączyć aparaty słuchowe Made for iPhone w parę z komputerem Mac, aby skonfigurować je w optymalny dla siebie sposób3.

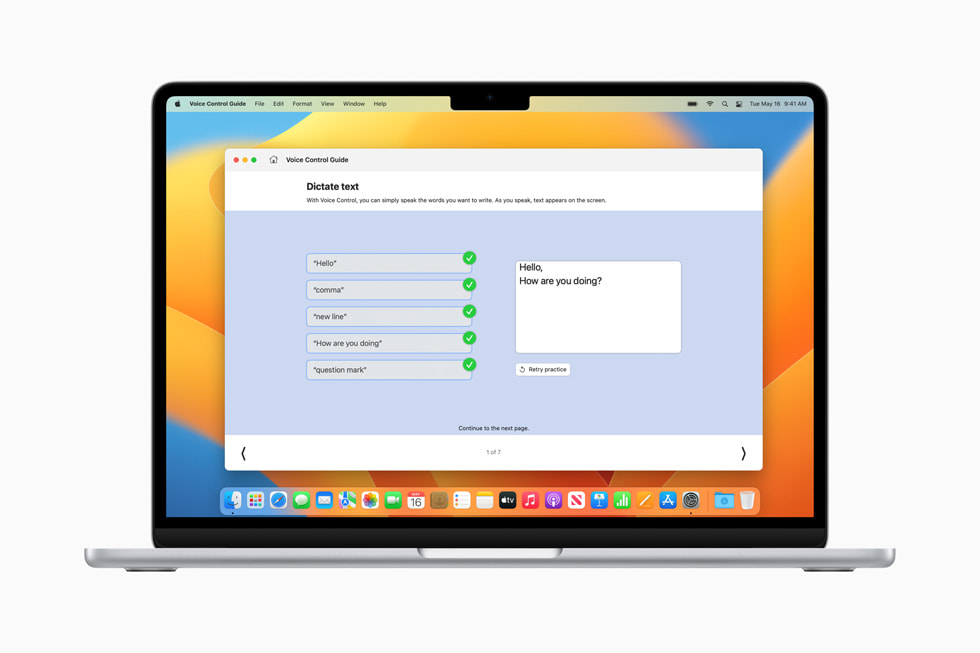

- Funkcję sterowania głosowego rozszerzono o sugestie fonetyczne modyfikujące tekst, by w wypadku podobnie brzmiących słów, takich jak angielskie „do”, „due” i „dew”, osoba korzystająca z konwersji mowy na tekst mogła wybrać właściwy wyraz4. Ponadto przygotowano przewodnik po sterowaniu głosowym, w którym można znaleźć wskazówki dotyczące stosowania poleceń dźwiękowych jako alternatywy dla pisania i dotykowej obsługi iPhone’a, iPada i Maca.

- Osoby z ograniczeniami fizycznymi i motorycznymi mogą korzystać z funkcji Sterowanie przełącznikami, która pozwala zmienić każdy przełącznik w kontroler do gier, aby grać w ulubione tytuły na iPhonie lub iPadzie.

- Osoby słabowidzące mogą teraz łatwiej dostosować rozmiar tekstu w aplikacjach na Macu, takich jak Finder, Wiadomości, Mail, Kalendarz i Notatki.

- Automatyczne zatrzymywanie obrazów z ruchomymi elementami, na przykład GIF‑ów, w Wiadomościach i Safari to z kolei rozwiązanie przygotowane dla osób wrażliwych na dynamiczne animacje.

- Gdy korzysta się z czytnika VoiceOver, Siri brzmi naturalnie i ekspresyjnie nawet przy dużej szybkości wypowiedzi. Prędkość tę można ponadto regulować w zakresie od 0,8x do 2x.

Światowe obchody Dnia Świadomości Dostępności

Z okazji Światowego Dnia Świadomości Dostępności firma Apple przygotowała nowe narzędzia, specjalne kolekcje i wiele innych niespodzianek:

- Od 18 maja usługa SignTime będzie dostępna w Hiszpanii, Korei Południowej, Niemczech i we Włoszech, dzięki czemu tamtejsi użytkownicy zyskają możliwość korzystania w Apple Store i na stronach Wsparcia Apple z dostępnego na życzenie tłumaczenia języka migowego. Z usługi korzystają już klienci w Australii, Francji, Japonii, Kanadzie, Stanach Zjednoczonych i Wielkiej Brytanii5.

- W wybranych salonach Apple Store na świecie przez cały tydzień będą prowadzone sesje edukacyjne przybliżające klientom ułatwienia dostępu, a w sklepie Apple Carnegie Library odbędzie się sesja Today at Apple z udziałem tłumaczki i interpretatorki języka migowego Justiny Miles. Ponadto salony Apple Store przez cały rok umożliwiają rezerwowanie terminów na sesje dla grup zorganizowanych, których członkowie chcą wspólnie poszerzać wiedzę o ułatwieniach dostępu.

- W aplikacji Skróty dodano opcję zapamiętywania. Za jej pomocą osoby o ograniczonych zdolnościach poznawczych mogą prowadzić w Notatkach dziennik wizualny, który będą miały stale pod ręką.

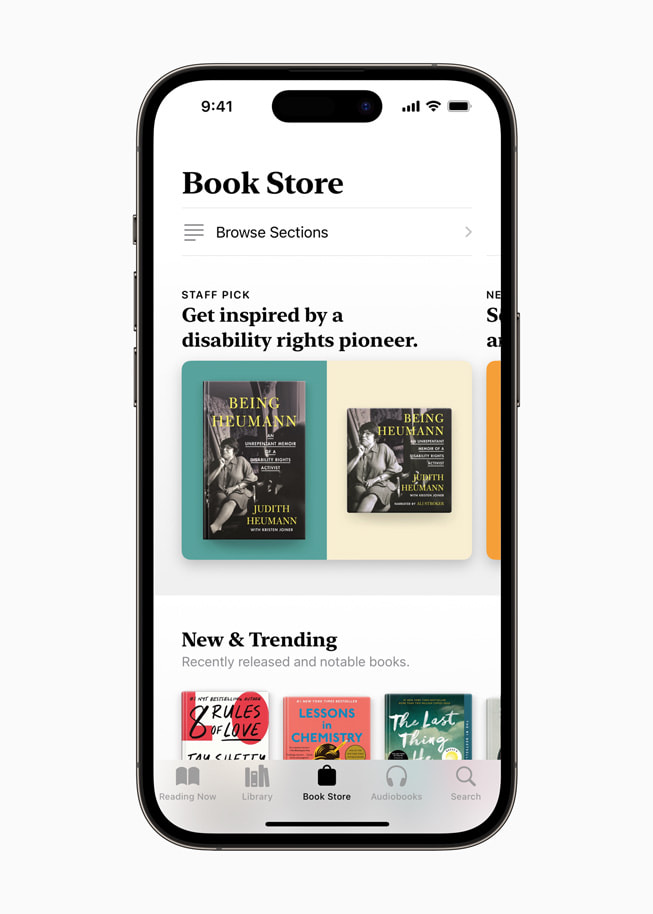

- W aplikacji Podcasty Apple przygotowano na ten tydzień kolekcję audycji poświęconych ułatwieniom dostępu. W aplikacji Apple TV pojawiły się filmy i seriale wybrane przez uznanych autorów reprezentujących osoby z niepełnosprawnościami. W Apple Books promowana jest książka Being Heumann: An Unrepentant Memoir of a Disability Rights Activist – wspomnienia Judith Heumann, pionierki ruchu na rzecz praw osób z niepełnosprawnościami. Z kolei w Apple Music będzie można zobaczyć klipy wideo z utworami z różnych gatunków wykonywanymi w amerykańskim języku migowym.

- Ponadto w tym tygodniu w Apple Fitness+ trener Jamie-Ray Hartshorne będzie prezentował za pomocą amerykańskiego języka migowego różne rozwiązania, które są efektem nieustannych wysiłków na rzecz umożliwiania aktywności fizycznej wszystkim chętnym. Jednym z takich udogodnień są Podpowiedzi audio, czyli krótkie opisy głosowe pomocne dla osób niewidomych i słabowidzących. Zamiast treningów Czas na spacer i Czas na bieg będzie zaś można odtworzyć treningi Czas na spacer lub jazdę i Czas na bieg lub jazdę przygotowane dla osób poruszających się na wózkach. Co więcej, podczas wszystkich treningów i medytacji trenerzy Fitness+ będą posługiwać się amerykańskim językiem migowym, wszystkie nagrania wideo będę dostępne z napisami w sześciu językach, a trenerzy uwzględnią w prezentowanych ćwiczeniach modyfikacje umożliwiające ich wykonywanie osobom o różnym poziomie sprawności.

- W App Store zaprezentowanych zostanie troje liderów społeczności osób z niepełnosprawnościami – Aloysius Gan, Jordyn Zimmerman i Bradley Heaven – którzy opowiedzą o tym, jak aplikacje do komunikacji wspomagającej i alternatywnej zmieniły ich życie jako osób, które nie mówią.

Udostępnij artykuł

Media

-

Tekst tego artykułu

-

Zdjęcia z tego artykułu

- Syntezę własnego głosu można wygenerować na urządzeniach iPhone, iPad i Mac z układem scalonym Apple. Rozwiązanie będzie działać w języku angielskim.

- Funkcja wskazywania i odczytywania będzie dostępna na urządzeniach iPhone i iPad ze skanerem LiDAR w języku angielskim, chińskim, francuskim, hiszpańskim, japońskim, kantońskim, koreańskim, niemieckim, portugalskim, ukraińskim i włoskim.

- Aparaty słuchowe Made for iPhone będzie można łączyć w parę z wybranymi komputerami Mac z czipem M1 i z wszystkimi komputerami Mac z czipem M2.

- Sugestie fonetyczne sterowania głosowego będą dostępne w języku angielskim, francuskim, hiszpańskim i niemieckim.

- Sesje z usługą SignTime są dostępne w Kanadzie i Stanach Zjednoczonych w amerykańskim języku migowym (ASL), w Wielkiej Brytanii w brytyjskim języku migowym (BSL), we Francji we francuskim języku migowym (LSF), w Japonii w japońskim języku migowym (JSL) i w Australii w australijskim języku migowym (Auslan). Od 18 maja usługa SignTime będzie dostępna w Niemczech w niemieckim języku migowym (DGS), we Włoszech we włoskim języku migowym (LIS), w Hiszpanii w hiszpańskim języku migowym (LSE) i w Korei Południowej w koreańskim języku migowym (KSL).