PRESSEMELDUNG

16 Mai 2023

Apple führt neue Funktionen für kognitive Barrierefreiheit ein, zusammen mit Live Speech, Personal Voice und Point and Speak in Lupe

Neue Softwarefunktionen für kognitive, sprachliche und visuelle Barrierefreiheit werden noch in diesem Jahr eingeführt

CUPERTINO, KALIFORNIEN Apple hat heute eine Vorschau auf neue Bedienungshilfen für Menschen mit kognitiven, visuellen, auditiven oder motorischen Einschränkungen gegeben sowie innovative Werkzeuge für Menschen vorgestellt, die nicht sprechen können oder bei denen die Gefahr besteht, dass sie ihre Sprachfähigkeit verlieren. Diese Aktualisierungen basieren auf Fortschritten in der Hardware und Software, beinhalten maschinelles Lernen auf dem Gerät, um die Privatsphäre der Nutzer:innen zu gewährleisten, und unterstreichen Apples langjährige Verpflichtung, Produkte für alle herzustellen.

Apple arbeitet eng mit Community-Gruppen zusammen, die ein breites Spektrum von Nutzer:innen mit Einschränkungen vertreten, um Funktionen zur Barrierefreiheit zu entwickeln, die das Leben der Menschen wirklich verbessern. Noch in diesem Jahr können Anwender:innen mit kognitiven Einschränkungen iPhone und iPad mit Assistive Access einfacher und unabhängiger nutzen; Personen, die nicht sprechen können, werden mit Live Speech während Anrufen und Unterhaltungen tippen können, um zu sprechen; und die, die Gefahr laufen, ihre Sprachfähigkeit zu verlieren, können Personal Voice nutzen, um eine künstliche Stimme zu erstellen, die wie die eigene klingt, um mit Familie und Freund:innen in Kontakt zu bleiben. Für blinde Nutzer:innen oder solche mit eingeschränktem Sehvermögen bietet der Erkennungsmodus in der Lupe die Funktion Point and Speak, die den Text, auf den man zeigt, erkennt und laut vorliest, um die Interaktion mit physischen Objekten wie beispielsweise Haushaltsgeräten zu erleichtern.

„Wir bei Apple haben immer daran geglaubt, dass die beste Technologie die ist, die für alle gemacht ist“, sagt Tim Cook, CEO von Apple. „Heute freuen wir uns sehr, neue Funktionen vorzustellen, die auf unserer langen Erfahrung aufbauen, Technologie zugänglich zu machen, damit alle die Möglichkeit haben, kreativ zu sein, zu kommunizieren und das machen zu können, was man liebt.“

„Barrierefreiheit ist Teil von allem, was wir bei Apple machen“, sagt Sarah Herrlinger, Senior Director of Global Accessibility Policy and Initiatives bei Apple. „Diese wegweisenden Funktionen sind unter Berücksichtigung des Feedbacks aus den Communities von Menschen mit Einschränkungen entwickelt worden, um eine Vielzahl von Nutzer:innen zu unterstützen und Menschen zu helfen, sich auf neue Weise zu verbinden.“

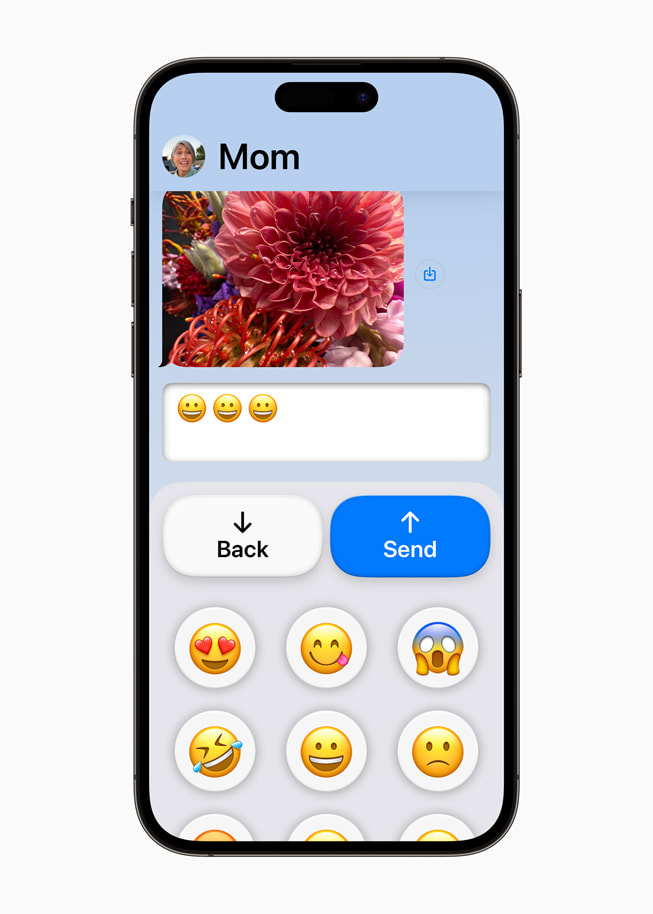

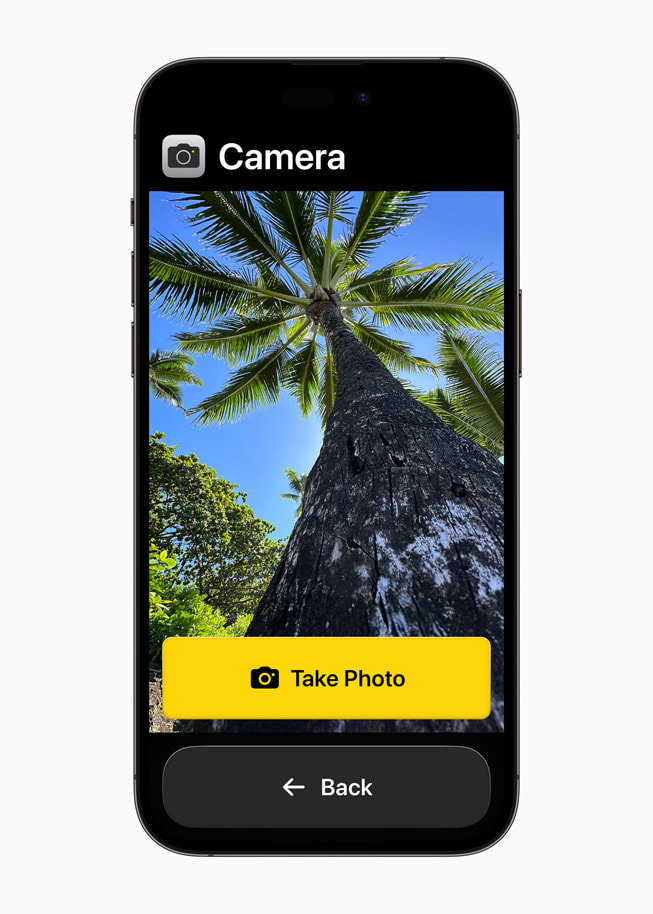

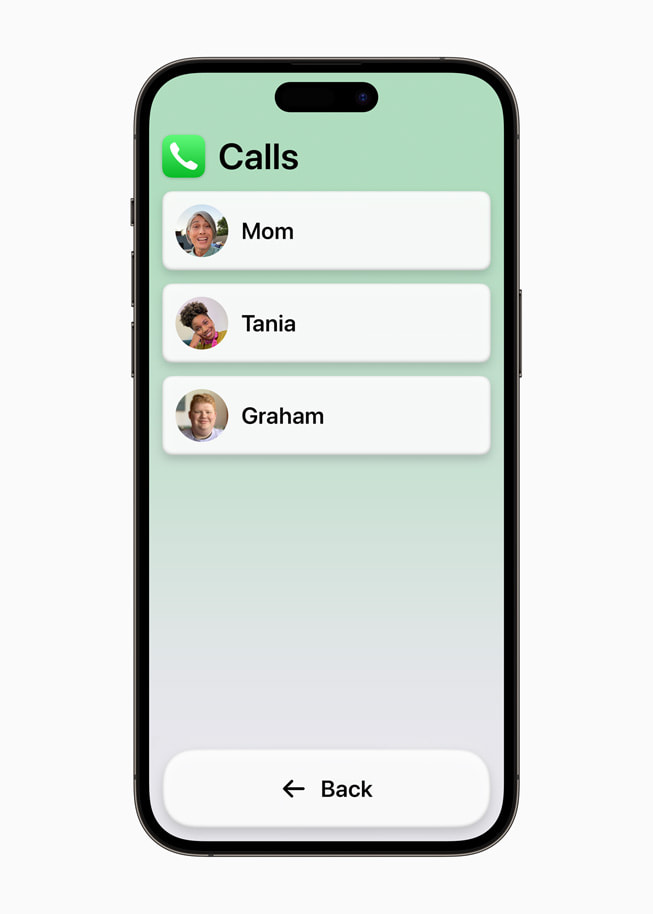

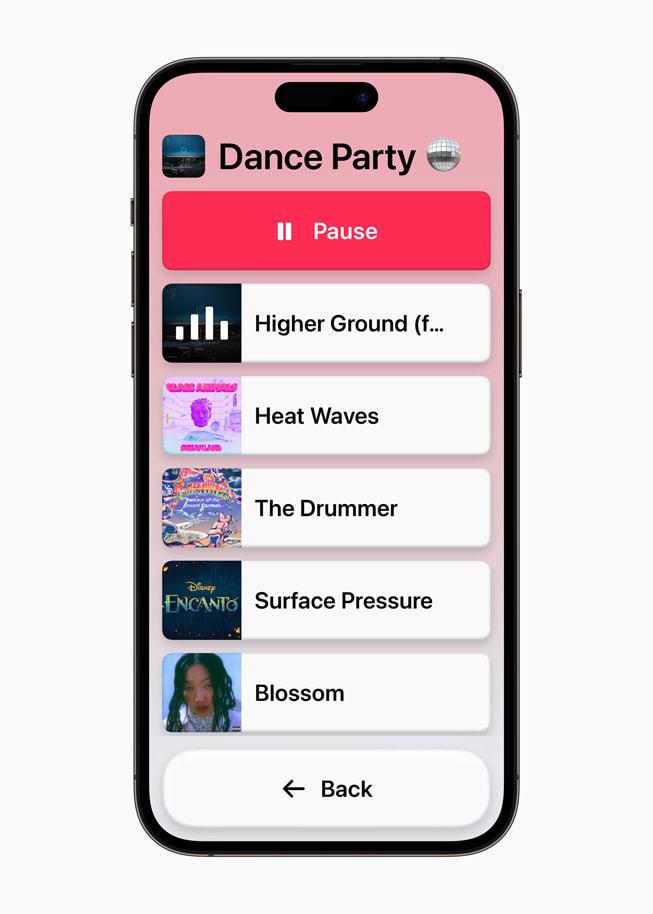

Assistive Access unterstützt Nutzer:innen mit kognitiven Einschränkungen

Assistive Access nutzt Innovationen bei der Darstellung, um Apps und Erlebnisse auf ihre wesentlichen Funktionen zu reduzieren und so die kognitive Belastung zu verringern. Die Funktion spiegelt das Feedback von Menschen mit kognitiven Einschränkungen und ihren vertrauenswürdigen Unterstützer:innen wider. Assistive Access konzentriert sich auf die Aktivitäten, die diesen Menschen Spaß machen und die grundlegend für iPhone und iPad sind: die Verbindung mit geliebten Menschen, das Aufnehmen und Genießen von Fotos und das Hören von Musik.

Assistive Access bietet ein spezielles Erlebnis für Anrufe und FaceTime-Calls, die in einer einzigen Telefon App zusammengefasst worden sind, sowie für Nachrichten, Kamera, Fotos und Musik. Assistive Access hat eine eigene Benutzeroberfläche mit kontrastreichen Schaltflächen und großen Beschriftungen sowie weitere Tools, mit denen vertrauenswürdige Unterstützer:innen das Erlebnis für die von ihnen unterstützte Person optimieren können. Für Nutzer:innen, die es vorziehen, visuell zu kommunizieren, bietet Nachrichten zum Beispiel eine reine Emoji Tastatur und die Möglichkeit, eine Videonachricht aufzunehmen, die sie mit geliebten Menschen teilen können. Anwender:innen und vertrauenswürdige Unterstützer:innen können auch zwischen einem eher visuellen, rasterbasierten Layout für ihren Startbildschirm und ihre Apps oder einem zeilenbasierten Layout für Nutzer:innen, die Text bevorzugen, wählen.

„Die Community der Menschen mit geistigen Einschränkungen und Entwicklungsstörungen strotzt nur so vor Kreativität, aber Technologie stellt für diese Menschen oft physische, visuelle oder Wissensbarrieren dar“, sagt Katy Schmid, Senior Director of National Program Initiatives bei The Arc of the United States. „Eine Funktion, die eine kognitiv zugängliche Erfahrung auf dem iPhone oder iPad bietet, bedeutet mehr offene Türen zu Bildung, Beschäftigung, Sicherheit und Autonomie. Es bedeutet, dass sich Welten erweitern und Potenziale ausgebaut werden.“

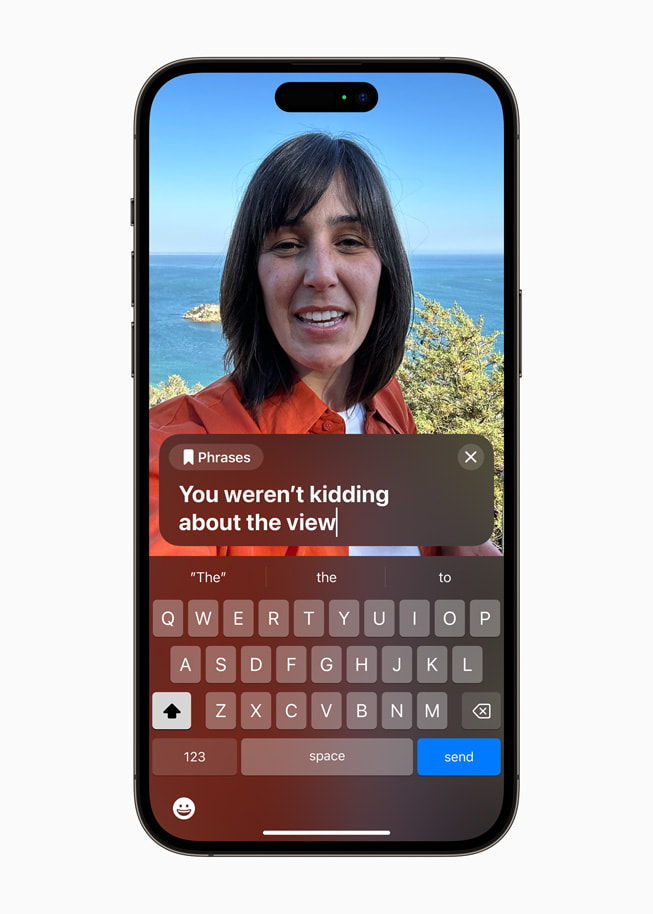

Live Speech und Personal Voice verbessern die Barrierefreiheit von Sprache

Mit Live Speech auf iPhone, iPad und Mac können Anwender:innen das, was sie sagen möchten, eintippen, damit es bei Telefonaten und FaceTime-Anrufen sowie bei persönlichen Gesprächen laut gesprochen wird. Man kann auch häufig verwendete Phrasen speichern, um sich bei lebhaften Gesprächen mit Familie, Freund:innen und Kolleg:innen schnell einbringen zu können. Live Speech ist entwickelt worden, um Millionen von Menschen auf der ganzen Welt zu unterstützen, die nicht sprechen können oder ihre Sprachfähigkeit im Laufe der Zeit verloren haben.

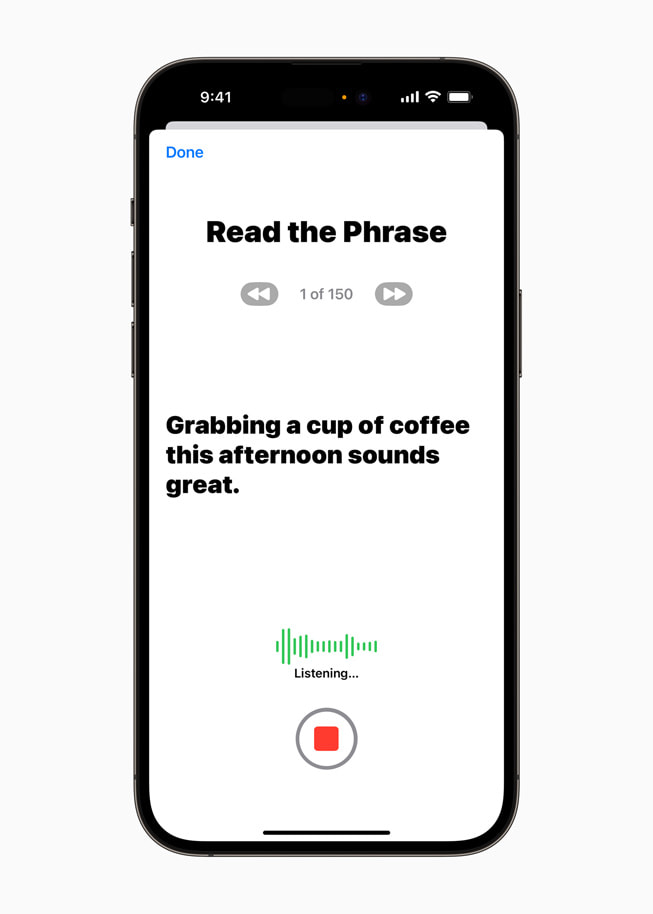

Für Nutzer:innen, bei denen die Gefahr besteht, dass sie ihre Sprachfähigkeit verlieren — wie beispielsweise Menschen, bei denen kürzlich ALS (Amyotrophe Lateralsklerose) diagnostiziert worden ist oder die an anderen Krankheiten leiden, die die Sprachfähigkeit nach und nach beeinträchtigen können — bietet Personal Voice eine einfache und sichere Möglichkeit, eine Stimme zu erzeugen, die wie die eigene klingt.

Anwender:innen können eine eigene Stimme erstellen, indem sie eine zufällige Reihe von Textaufforderungen vorlesen, um 15 Minuten Audio auf dem iPhone oder iPad aufzunehmen. Diese Bedienungshilfe im Bereich Sprache nutzt maschinelles Lernen auf dem Gerät, um die Informationen der Nutzer:innen sicher zu halten, und lässt sich reibungslos in Live Speech integrieren, sodass man mit der eigenen Stimme sprechen kann, wenn man sich mit den Liebsten verbindet.1

Personal Voice ermöglicht es Anwender:innen, die Gefahr laufen, ihre Sprachfähigkeit zu verlieren, eine Stimme zu erzeugen, die wie ihre eigene klingt, und lässt sich reibungslos in Live Speech integrieren, so dass Anwender:innen mit ihrer eigenen Stimme sprechen können, wenn sie sich mit ihren Liebsten verbinden.

„Am Ende des Tages ist es das Wichtigste, mit Freunden und Familie kommunizieren zu können“, sagt Philip Green, Vorstandsmitglied und ALS-Befürworter bei der gemeinnützigen Organisation Team Gleason, der seit seiner ALS-Diagnose in 2018 erhebliche Veränderungen an seiner Stimme erfahren hat. „Wenn man ihnen sagen kann, dass man sie liebt, und zwar mit einer Stimme, die wie die eigene klingt, macht das den Unterschied aus — und dass man seine künstliche Stimme in nur 15 Minuten auf dem iPhone erstellen kann, ist außergewöhnlich.“

Der Erkennungsmodus in der Lupe ermöglicht Point and Speak für blinde Nutzer:innen oder solche mit eingeschränktem Sehvermögen

Point and Speak in Lupe erleichtert Nutzer:innen mit eingeschränktem Sehvermögen die Interaktion mit physischen Objekten, die mehrere Beschriftungen haben. Bei der Verwendung eines Haushaltsgeräts — wie etwa einer Mikrowelle — kombiniert Point and Speak die Eingaben der Kamera App, des LiDAR-Scanners und des geräteeigenen maschinellen Lernens, um den Text auf jeder Taste anzusagen, wenn man den Finger über die Tastatur bewegt2Point and Speak ist in der App Lupe auf iPhone und iPad integriert, funktioniert hervorragend mit VoiceOver und kann mit anderen Funktionen der Lupe wie Personenerkennung, Türerkennung und Bildbeschreibungen verwendet werden, um Anwender:innen bei der Navigation in der physischen Umgebung zu unterstützen

Point and Speak in Lupe erleichtert Nutzer:innen mit eingeschränktem Sehvermögen die Interaktion mit physischen Objekten, die mehrere Beschriftungen haben.

Weitere Funktionen

- Gehörlose oder schwerhörige Nutzer:innen können Made for iPhone-Hörgeräte direkt mit dem Mac koppeln und sie an ihren Hörkomfort anpassen.3

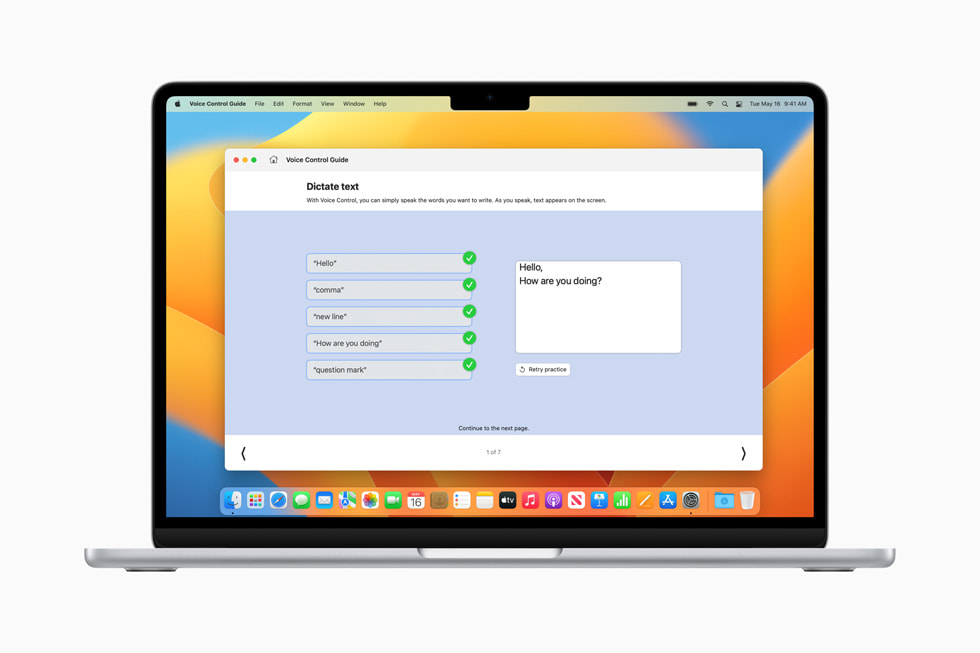

- Sprachsteuerung fügt phonetische Vorschläge für die Textbearbeitung hinzu, sodass Nutzer:innen, die mit ihrer Stimme tippen, das richtige Wort aus mehreren ähnlich klingenden Wörtern auswählen können, wie beispielsweise im Englischen bei „do“, „due“ und „dew“.4Darüber hinaus können Anwender:innen mit dem Guide zur Sprachsteuerung Tipps und Tricks für die Verwendung von Sprachbefehlen als Alternative zu Touch und Tippen auf iPhone, iPad und Mac lernen.

- Nutzer:innen mit körperlichen und motorischen Einschränkungen, die Schaltersteuerung verwenden, können jeden Schalter in einen virtuellen Game-Controller verwandeln, um ihre Lieblingsspiele auf iPhone und iPad zu spielen.

- Für Anwender:innen mit eingeschränktem Sehvermögen ist es jetzt noch einfacher, die Textgröße in Mac Apps wie Finder, Nachrichten, Mail, Kalender und Notizen anzupassen.

- Nutzer:innen, die empfindlich auf schnelle Animationen reagieren, können Bilder mit bewegten Elementen, wie beispielsweise GIFs, in Messages und Safari automatisch anhalten.

- Für Anwender:innen von VoiceOver klingen Siri-Stimmen auch bei hoher Sprachrückmeldung natürlich und ausdrucksstark. Außerdem kann man die Geschwindigkeit, mit der Siri spricht, individuell anpassen, wobei die Optionen von 0,8x bis 2x reichen.

Der Welttag der Barrierefreiheit wird auf der ganzen Welt gefeiert

Anlässlich des Welttags der Barrierefreiheit stellt Apple diese Woche neue Funktionen, kuratierte Sammlungen und mehr vor:

- Gebärdensprache startet am 18. Mai in Deutschland, Italien, Spanien und Südkorea, um Apple Store und Apple Support Kund:innen mit Gebärdensprachdolmetscher:innen zu verbinden. Dieser Service ist bereits für Kund:innen in den USA, Kanada, Großbritannien, Frankreich, Australien und Japan verfügbar.5

- Ausgewählte Apple Stores auf der ganzen Welt bieten die ganze Woche über Informationsveranstaltungen an, in denen Kund:innen Bedienungshilfen kennenlernen können. In der Apple Carnegie Library wird eine Today at Apple Session mit der Gebärdensprachdolmetscherin Justina Miles stattfinden. Mit Gruppenreservierungen — die das ganze Jahr über möglich sind — sind die Apple Stores ein Ort, an dem sich Gruppen aus der Community gemeinsam über Funktionen zur Bedienungshilfe informieren können.

- Shortcuts fügt Remember This hinzu, die Nutzer:innen mit kognitiven Einschränkungen hilft, ein visuelles Tagebuch in Notes zu erstellen, um sehr einfach nachschlagen und besser nachdenken zu können.

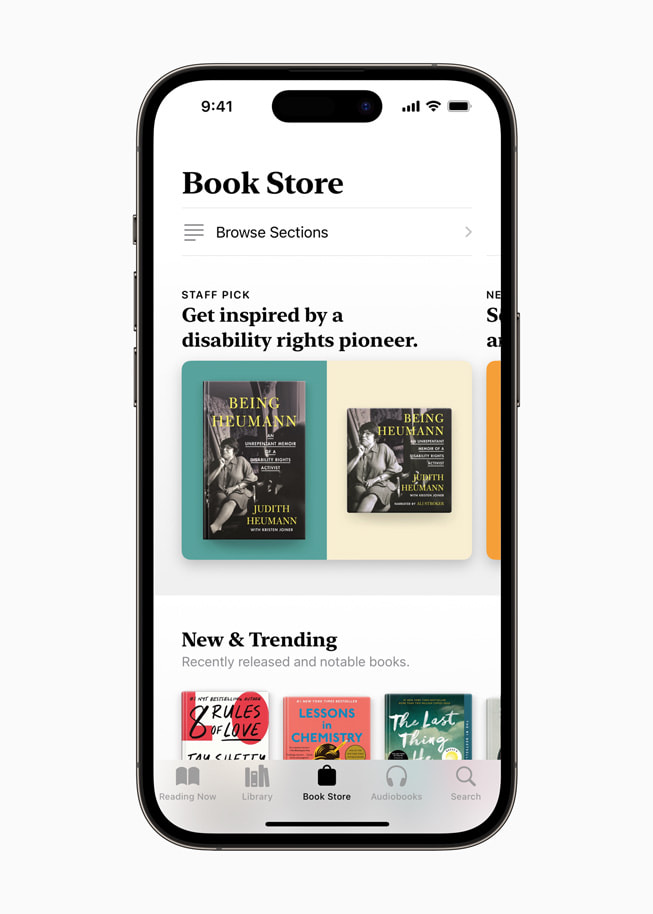

- In dieser Woche wird Apple Podcasts eine Sammlung von Sendungen über die Auswirkungen barrierefreier Technologien anbieten; die Apple TV App stellt Filme und Serien vor, die von namhaften Erzähler:innen aus der Community der Menschen mit Einschränkungen kuratiert worden sind; Apple Books stellt Being Heumann: An Unrepentant Memoir of a Disability Rights Activist, die Memoiren der Pionierin des Behindertenrechts, Judith Heumann, in den Mittelpunkt und Apple Music bietet genreübergreifende Musikvideos in amerikanischer Gebärdensprache (ASL).

- Diese Woche in Apple Fitness+ integriert Trainerin Jamie-Ray Hartshorne ASL und hebt all die Funktionen hervor, die Anwender:innen zur Verfügung stehen und Teil der andauernden Bemühungen sind, Fitness für alle zugänglicher zu machen. Zu den Funktionen gehören Audio-Hinweise, die zusätzliche kurze, beschreibende verbale Hinweise geben, um blinde oder Nutzer:innen mit eingeschränktem Sehvermögen zu unterstützen, und die Episoden „Zeit zum Gehen“ und „Zeit fürs Laufen" werden zu „Zeit zum Gehen oder Schieben“ und „Zeit fürs Laufen oder Schieben“ für Rollstuhlfahrer:innen. Darüber hinaus binden die Fitness+-Trainer:innen ASL in jedes Training und jede Meditation ein, alle Videos enthalten Untertitel in sechs Sprachen, und die Trainer:innen demonstrieren Modifikationen in den Trainings, so dass man auch mit unterschiedlichem Leistungsniveau mitmachen kann.

- Im App Store werden drei führende Persönlichkeiten aus der Community der Menschen mit Einschränkungen — Aloysius Gan, Jordyn Zimmerman und Bradley Heaven — ins Rampenlicht rücken, die über ihre Erfahrungen als Menschen ohne Sprachfähigkeit und die transformativen Auswirkungen von Apps für die Unterstützte Kommunikation in ihrem Leben berichten werden.

Artikel teilen

Media

-

Text dieses Artikels

-

Bilder zu dieser Pressemeldung

- Personal Voice kann mit iPhone, iPad und Mac mit Apple Chips erstellt werden und wird auf Englisch verfügbar sein.

- Point and Speak wird auf iPhone- und iPad-Geräten mit dem LiDAR-Scanner in Englisch, Französisch, Italienisch, Deutsch, Spanisch, Portugiesisch, Chinesisch, Kantonesisch, Koreanisch, Japanisch und Ukrainisch verfügbar sein.

- Nutzer:innen können Made for iPhone-Hörgeräte mit ausgewählten Mac-Geräten mit M1 Chip und allen Mac-Geräten mit M2 Chip koppeln.

- Die phonetischen Vorschläge der Sprachsteuerung werden in Englisch, Spanisch, Französisch und Deutsch verfügbar sein.

- Sessions in Gebärdensprache sind in den USA und Kanada in Amerikanischer Gebärdensprache (ASL), in Großbritannien in Britischer Gebärdensprache (BSL), in Frankreich in Französischer Gebärdensprache (LSF), in Japan in Japanischer Gebärdensprache (JSL) und in Australien in Australischer Gebärdensprache (Auslan) verfügbar. Ab 18. Mai werden Sessions mit Gebärdensprache in Deutschland mit der Deutschen Gebärdensprache (DGS), in Italien mit der Italienischen Gebärdensprache (LIS), in Spanien mit der Spanischen Gebärdensprache (LSE) und in Südkorea mit der Koreanischen Gebärdensprache (KSL) verfügbar sein.